有人说,人工智能(AI)是未来。随着互联网的快速发展,在人工智能和智能机器新时代,深度学习正以与历史上其他计算模型截然不同的方式改变着世界。机器学习(ML) 正在迅速成熟。

深圳市立尔讯科技一直专注高端服务器行业应用定制服务,公司主要提供:定制服务器,四子星服务器、双子星服务器、低延时服务器等产品和相关服务,研发能力强劲,多项专利打造定制化服务器应用,致力打造高端服务器云智能应用平台。

如今,我们能够把大量数据输入机器学习应用中,后者能学会精确预测可能出现的结果。随着训练数据集的扩大,深度学习(DL) 模型的精确性呈指数级增长。数以万亿的互联设备向系统发送数据,数据集的规模可达数百TB。

机器学习革命的成果在互动语音、视觉搜索、无人驾驶汽车、实时欺诈检测、对假期照片中的人脸进行识别的社交网络等领域得到了很好的体现。它渗透各行各业,影响无处不在。

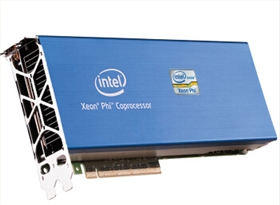

经过长达八年各种相关研究,Intel终于正式退出了MIC众核架构的Xeon Phi协处理器,为超算带来了一股新鲜势力

Xeon Phi处理器在很大程度上继承了流产的独立显卡项目Larrabee的遗志,外部造型看似显卡,其实是和Tesla类似的专用加速计算卡,其架构采用顺序、双发射x86,支持64位运算,每个核心支持最多四个线程,最多61个核心、244个线程,并且每个核心都搭配一个512-bit SIMD适量引擎。

当然了,这里的“核心”跟Tesla里边的CUDA核心是没有直接可比性的,他们分别来自CPU、GPU的世界。

让我们揭开全新英特尔至强融核产品家族的神秘面纱,了解其在处理ML 工作负载方面的非凡优势。

“英特尔®至强 融核™处理器特性”

在设计第二代英特尔至强融核芯片时,发明了支持自启动的融核处理器,不需要在购买额外的处理器运行操作系统,也不需要通过PCIe插槽传输数据。

英特尔至强融核处理器x200包含72 个处理器内核,每个内核支持2 个英特尔® 高级矢量扩展指令集512(英特尔® AVX-512)SIMD 处理单元,每内核浮点性能显著提升。常用的ML 算法均可从中受益,如浮点乘法和乘加融合指令(FMA)。英特尔至强融核处理器x200提供高达每秒6 万亿次浮点运算的计算能力。多核、多线程的功能和高带宽封装内存子系统(多通道DRAM)及英特尔® Omni-Path 架构(英特尔® OPA)的集成结构技术相结合。

高带宽集成内存(高达16 GB MCDRAM)保证数据快速传输到内核,并为平台额外提供高达384 GB 商用DDR4 内存。程序员可以通过指定数据的大小及时间来管理内存。MCDRAM 使用户可以灵活地对数据高速缓存,不必担心内存管理。(MCDRAM 可以配置为三级高速缓存、非一致性内存访问- 可分配内存和高速缓存和内存的混合组合。)

当处理大型ML/DL 工作负载时,从一个节点到千百个节点的扩展能力是至关重要的。借助英特尔OPA 架构,英特尔至强融核处理器x200 能够以近乎线性的方式扩展内核和线程。在编码层面,通过架构可以最少的编程快速高效地从远程存储获取数据,并放入本地高速缓存。

这些创新为机器学习和深度学习提供了优质的训练时间。 比如,AlexNet 训练方面,相对于单节点而言,128 节点英特尔至强融核处理器x200 的训练时间减少了50 倍。 进行GoogLeNet 训练时,32 节点英特尔至强融核处理器x200 的扩展效率达到87%,比最新公布的最高数据超出38%。

应用只有并行化,才能利用大规模并行多核、多线程架构。否则,你只能获得单核、单线程性能。

英特尔至强融核处理器x200 的每个内核包含多个矢量处理单元,所以整体计算密度更高,成为抵消单核、单线程性能的一个因素。因此,如果你的工作负载能受益于高水平的并行性和线程并行性,英特尔至强融核处理器把更多计算融入更小的区域,功耗低于其他解决方案。

“二进制兼容”

从软件角度看,第二代英特尔至强融核处理器与包括英特尔至强® E5 家族处理器在内的x86 架构处理器之间是二进制兼容的。这意味着你只需要实施一次代码现代化,第二代英特尔至强融核处理器和现有的基于英特尔至强处理器的服务器的训练效率会显著提高。“现代化”不是让用户自己写ninja 并行代码。我们正在利用通用英特尔® 数学核心函数库等工具,简化基于x86 架构的通用CPU 的ML/DL 代码的并行处理,数学核心函数库包括新的扩展指令集,用来优化现已推出的英特尔® MKL 2017 Beta 版的深度神经网络。通过我们的不懈努力,在没有升级硬件的情况下,深度学习应用的性能提升了大约30 倍。

“总结”

第二代英特尔至强融核产品家族进一步实现了英特尔普及ML 和多层神经网络的目标,这也是深度学习应用的计算密集训练阶段所必需的,为了实现这一目标,英特尔不断的对各类工作负载进行优化,以提高机器的决策能力。

文章摘自英特尔精英汇

LR4424 4U 四路机架式服务器

LR4424 4U 四路机架式服务器 【华章服务器】H740 2U RACK 24SATA/SAS +2NVme

【华章服务器】H740 2U RACK 24SATA/SAS +2NVme 【华章服务器】 H740 2U RACK 12SATA/SAS +2NVme

【华章服务器】 H740 2U RACK 12SATA/SAS +2NVme 【华章服务器】H640 1U RACK 10SATA/SAS +2Nvme

【华章服务器】H640 1U RACK 10SATA/SAS +2Nvme